父の先見

人類最悪にして最後の発明

ダイヤモンド社 2015

James Barrat

Our Final Invention : Artificial Intelligence and the End of the Human Era 2013

[訳]水谷淳

編集:廣畑達也

装幀:松昭教(bookwall)

この1週間(2016年3月)、ソウルからのニュースで世界は沸き返った。イ・セドルは唸っていた。セドルだけではない。井山裕太も唸った。井山は囲碁史上初の6冠を達成した極め付けのチャンピオンである。こんなにもあっさりとプロの碁打ちが負けるとは思っていなかったのだ。

グーグル傘下ベンチャー企業が開発した「アルファGo」が韓国の囲碁チャンピオンのイ・セドル9段をあっさり連破したのである(#その後、セドルが一矢を報いた。「人類の叡知の歴史を築いた」という感想には、剣ヶ峯に立たされた人知の悲壮感が漂っていた)。

半年前までは人工知能はチェスや将棋には届くが、複雑な囲碁にはまだまだ届かないと言われていたのだが、グーグルが4億ドルで買収したブレイン集団ディープマインド・テクノロジーズがやすやすとその壁を突破してみせたのだ。デミス・ハサビス(ディープマインドCEO)は「エキスパートシステムなんかじゃない。機械学習のディープラーニングが一挙に進んだのだ」と誇った。ディープマインドは「AIのアポロ計画」を標榜した集団で、2015年の10月には欧州囲碁チォンピオンのファン・フイも破っていた。

ディープラーニングでは、あらかじめ想定されるできるだけ多くの「問題」と「答え」とをコンピュータに入れておくのだが、その「解き方」は入力しない。そこはコンピュータが自分で考える。それが人工知能なのである。しかも囲碁にはチェスや将棋のように「ポーン・クイーン」「歩・飛車」といった駒の特性がない。「キング」「王将」のように守らなくてはならない駒もない。すべての戦況と作戦は石のアドレスの相互位置関係から判断する。「アルファGo」はこれらの難問も約3000万にのぼる既存のプロの棋譜から判断できるようにした。

いまじわじわと人工知能をめぐる一部の研究が“お化け”をめざそうとしている。一言でいえばAGI(人工汎用知能 Artificial General Intelligence)に向かっているように見える。

さまざまな知的機能をもつAIなら、すでに家電製品、ケータイ、スマホ、クラウドコンピュータ、産業用ロボット、自動車、お掃除ロボット、電子ゲーム、将棋ソフト、医療診断装置、遺伝工学解析、環境変化測定、金融工学、航空制御システム、戦略兵器などに、多寡の大小はあるもののあれこれ備わっている。世の中の目ぼしいハイテクシステムや製品でAIがかかわらないもののほうが少ない。

実際にも、AIをもっと賢くもっと強力にもっと使いやすくしようとしているR&Dは企業や研究所の中で鋭意驀進中だ。目立つところでいえば、たとえばIBM、サイコープ、グーグル、DARPA(国防高等研究計画局)、ノヴァメンテ、NARS、Cyc、ヌメンタ、セルフアウェア・システムズ、AGIRI、SOAR、ヴァイカリアス・システムズ、NELL(カーネギーメロン大学)、Sentience、AIXItlなどは、そうしたAI進化の開発に余念がない(#正確には認知アーキテクチャの研究開発だよね)。

AIがAGIをめざし、そのAGIがエクサバイトクラス(1エクサバイトは10億文字の10億倍)の知識を学習していけば、そのうち科学者たちが冗談めいて“ビジーチャイルド”と揶揄してやまないASI(人工超知能 Artificial Super Intelligence)に向かうことになる。

原理的にはASIは自分自身の複製をいくらだってつくるだろうから、人間が電源を抜かないようにいくつもの自身の延命のための選択肢をふやし、感染力の高いプログラムをいくつも用意したり、外からの介入を利用して逃げ出せるワーム(#ASIが自己複製して増殖するプログラムをマシン自身が予定する)をつくったり、自身のソースコードを圧縮して暗号化し、人間社会のソフトウェアや音声ファイルの中に隠れることもするだろう。

そういうAGIがあれば、そいつは『2001年宇宙の旅』のHAL9000の二の舞や『ターミネーター』のスカイネットの“暴走”と“失敗”を回避してしまう(#AIが人間さまの魂胆をすばやく察知するわけだ)。

すでにAGIの機能を部分的にもつシステムは情報軍事戦略の各所に用いられているという。SCADA(監視制御データ収集システム)、スタックスネット、マルウェア(悪意のあるソフトの蔑称でもある)、デュークー、フレームなどと名付けられている戦略的電子送電網がそうなっている。他方、各国のインテリジェント(諜報)機能システム、正体不明のハッカー集団の未公開システムなども、すでにどこかがAGIめいているはずだ。

これがAGIだというものはまだ登場していないけれど、AGIなんて夢のまた夢だという時期はちょっぴり過ぎたようだ。アダプティヴAIという会社をやっているピーター・ヴォスははっきりと「うちの会社はAGIをめざしているんだ」と言っているし、ペイパル社を創業したピーター・ティールはAIに専念する3つのステルス企業にけっこうな投資をしていると聞いた。

一番あやしいのはどう見てもグーグルだが、『エージェント アプローチ 人工知能』(共立出版)の共同著者で、グーグルの研究責任者でもあるピーター・ノーヴィグは「わが社はAGIなんてやっていないよ」と話題をそらし、広報担当のジェイソン・フリーデンフェルズも「AGIは想像上の思考マシンであって、われわれはあくまでパターンマッチングのための統計的モデルを研究しているにすぎない」と言っているのだが、さあ、どうか。

そもそも共同創業者のラリー・ペイジが「究極のサーチエンジンをつくるのが目標だ」と断言してきたのだし、いまや話題のグーグルX(#AI専門のセバスティアン・スランが立ち上げた自律走行自動車の開発主体)はあきらかにステルス企業のはずなのである。スタンフォードの人工知能研究所の元所長アンドリュー・ン(ロボット工学者)も加わっている。

おそらくグーグルは2012年にレイ・カーツワイルを技術役員に迎え、ディープラーニングの第一人者ジェフリー・ヒントン(トロント大学教授)が立ち上げたDNNリサーチを買収したあたりから、AGIまっしぐらになっていると思われる。「アルファGo」のディープマインド・テクノロジーズ社の買収など、そのごくごく一部の計画だろう。

元DARPA長官のレジーナ・ドゥーガンもいっとき招聘雇用されていたと聞くし、とくに社員が数十人ほどのディープマインド・テクノロジーズをフェイスブックと競り勝って4億ドル(約420億円)で落としたのは、その魂胆が奈辺にあるかをあからさまにした。

はたして人工知能がこんなふうに熟達していっていいものか。人間は有能な機械に支配されるのではないか。そのうちどこかの国が“AGI不拡散条約”(!)なんてものを呼びかけることになるのではないか。

そんな心配や懸念を科学者や技術者があちこちで表明するようにもなった。先頭を切ったのは不可知論者のスティーヴン・ホーキング(192夜)やスチュワート・ラッセル(コンピュータ科学者)、ノーベル物理学者のフランク・ウィルチェック、破竹のベンチャー起業家イーロン・マスクたちである。ついでオックスフォードの倫理学者ニック・ボストロム、生命未来研究所の所長マックス・テグマークらが、人工知能のAGI化に「待った」をかけた。

人工知能が仕事を奪うというつまらない議論もやかましい。経済学者のタイラー・コーエンは「AIによってホワイトカラーの仕事がかなり失われるだろう」と危惧し、リサーチ屋のデロイト社はイギリスの仕事のうちの35パーセントが20年のうちにロボットに置換されると予想した。

最近はビル・ゲイツ(888夜)もAGI反対派に入る表明をしたが、これはグーグルへのやっかみ半分なので、どこまで本気なのかはわからない。

AIの危険性を研究する機関もいくつかできた。バークレーの機械知能研究所(MIRI)はそのひとつで、所長のマイケル・ヴァッサーは年に一度の「シンギュラリティ・サミット」を主宰する。

ヴァッサーはMBAを取得し、オンライン音楽のライセンスで一儲けして(サー・グルーヴィー社)、さてどうするかというとき、2003年にエリエゼル・ユドカウスキーに会った。ユドカウスキーはAIボックスの実験をしていた。AIがどこで人間の認知を裏切るのかをテストする装置だ。そのヴァッサーとユドカウスキーに、さらに応用合理性センター(CFAR)が加わった。いまやAIをどう監視するのかという時代に同時突入しているのである。

スティーヴ・オモアンドロもAGIの危険を懸念する。オモアンドロは『物理学における幾何摂動理論』などの教科書で一世を風靡した微分幾何学者だった。そのうち人工知能研究に分け入って、AI用のコンピュータ言語 StarLisp や Sather を開発したり、ウルフラム・リサーチ社の「マセマティカ」の共同開発者となって、AI読唇術のプロトタイプ(#これは画像認識の草分けだ)を発表するまでに至っていた。

が、このへんからオモアンドロは「人工知能は価値観をもっていない」という“冷たい事実”に気が付き(#そんなこと当たり前なのに)、そこをどうするかという難問を自分に課するようになったようだ。とくに戦場や病院で「不適切なプログラミング」が頻発していることに眉を顰めた。

オモアンドロが気にするのは、「自己を意識して自己進化するシステム」(ようするにAGI)には、①効率性、②自己保存、③資源獲得、④創造性をほしがる強い傾向があるので、これが絡まってAGIにはたらくと問題を厄介にするだろうというものだ。

機械が人間の能力を優越するとか、機械が人間の仕事を代行するなんてことは、実はずっとむかしからのことだった。いまさらのことじゃない。

投擲からオナゲルへ、ぶん殴りから大砲へ、乗馬から蒸気機関車へ、大声から電話へ、模写から写真へ、そろばんから電卓へ、そして電卓からPCへ、機械はいつだって人間の仕事をうんと手伝ってきたのだし、べらぼうな効率を上げてきた。いまさらAIばかりに文句を言う筋合いはないはずなのだ。

それでもなんだか心配になる。思うにそれはAIに才知が吸い取られるような気がするからだろうが、それもノーバート・ウィーナーがサイバネティクスで「フィードバック回路」を重視して以来のことで、「吸い取り」や「移譲」が恐いというなら、すべてをマンマシン・システムどまりにしておくべきなのである。

本書はアメリカの気鋭のフリーTVプロデューサーが書いた。バラットが構成したナショジオのドキュメンタリー番組を何本か見たことがあるが、入念な構成だった。本書は長年の取材にもとづいた人工知能の将来に対する警告書で、バラットの最初の著書である。

テレビ番組と違ってこの手のものとしては構成はイマイチだったが(#あのね、本のつくりとテレビのつくりは違うんだよね)、中身はよく書けていた。この手のものというのは、やみくもな技術過信批判本のことで、それを言っちゃあおしまいよという類いの本のことだが、この本はよくある警告書の嫌みはなく、そのぶん読ませた。ぼくも実はレイ・カーツワイルが2012年にグーグルの技術担当役員に迎えられたと聞いたとき、これはヤバイなと思っていたのである。

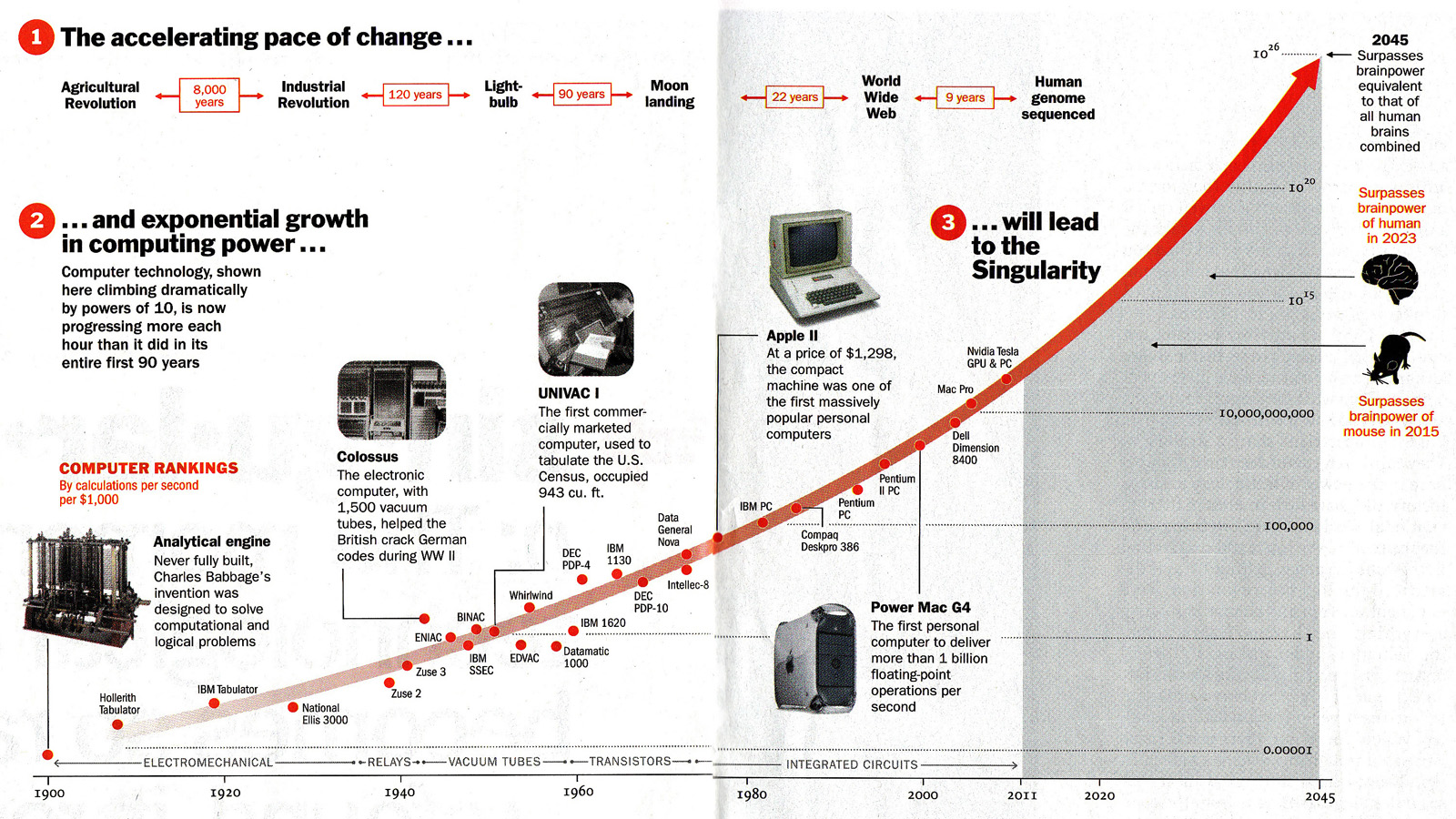

カーツワイルは大脳皮質をコンピュータでシミュレートしたいという構想の持ち主で(Neocortex Simulatorという)、あとで説明するが、「シンギュラリティ(特異点)理論」(#カーツワイルのシンギュラリティは技術的特異点ということ)の提唱で有名だ。すでに底抜けの楽天科学思想による『スピリチュアル・マシーン』(翔泳社)や『ポストヒューマン誕生』(NHK出版)といった著書も書いている。

バラットはそのカーツワイルにも何度も取材をかけ、そのうえで本書はAIがAGIやASIに向かうことに強い疑問を呈したのだった。しかし、読んでみてなるほどやりすぎだと思うところもあるが、はたしてこれらの疑問がすべて妥当なのかどうか、判断するのはけっこう難しい。

どんな機械もそうなのだが、人工知能もうまく使いさえすればかなり役に立つものでもあるからだ。

人工知能(AI=Artificial Intelligence)という考え方は、ライムンドゥス・ルルスやライプニッツ(994夜)が「ローギッシェ・マシーネ」(論理機械)を先駆的に構想したこと、ラプラスらが確率論をつくりだしたこと、あるいはブールやフレーゲの数学(#1592夜モーリス・クライン『不確実性の数学』参照)ができあがってきたこと、チャールズ・バベッジが階差機関を試作したりしたことなどをべつにすると(#第8夜『バベッジのコンピュータ』参照)、1950年にアラン・チューリングが「計算する機械と知性」を書いたときから始まっていた。

人工知能という言葉が生まれたのはそれから数年後の1956年のダートマス会議でのことで、ジョン・マッカーシーが提案した。ダートマス会議はマッカーシー、マーヴィン・ミンスキー(452夜)、アレン・ニューエル、ハーバート・サイモン(854夜)らの俊英が中心になったもので、そのときニューエルとサイモンは「ロジック・セオリスト」のデモをした。

3年後、マッカーシーはプログラミング言語LISPを考案し、そこにミンスキーが加わって4年後にはMITにAI研究所をつくっている(#マッカーシーとミンスキーは1952年にクロード・シャノンがベル研究所に雇った二人の研究員であり、大学時代はウォーレン・マカロックの学生だった。いま振り返ると、すべてはシャノン、ウィーナー、マカロック、マッカーシーたちから始まっているんだね)。

人工知能の歴史は順風満帆ではなかった。いまふりかえれば二つの熱化期と二つの冬を超えて、今日の過熱の再来を迎えているのだが、まだまだどうなるかはわからない。

60年代の第1次ブームで盛り上がったのは、神経生理学者ウォーレン・マカロックと数学者ウォルター・ピッツによる電子神経方程式の提案と、これをヒントにしたフランク・ローゼンブラットによる「パーセプトロン」の提案とその汎用化によるところが大きく、これで情報の入力層と出力層からなる基本的なニューラルネットの階層モデルができた。「パーセプトロン」は記号処理によるかなり単純な仕掛けではあったが、初めて「脳の工学モデル」をめざしたものだった。それでもコンピュータが三角形と四角形を認知できたのはこれが最初だったのである。

けれども、この初期ニューラルネットは線形分離しかできない計算力しかもっていなかったので、おっつけ限界が見えた。ぼくも会ったことがあるが、ヒューバート・ドレイファスらが『コンピュータには何ができないか』(産業図書)などで、こんなAIは幻想にすぎないことを暴き立てたものだ。こうして最初の冬がやってきた。

そこでみんなが反省した。急に「脳の工学モデル」をめざしてもむりだ、コンピュータに入れるべきはもっと熟達した知識情報だろうということになり、「知識工学」ともいうべき試みがさまざまに組み立てられた。これが第2次ブームとなり、各界の専門知識や知識スキルを移植する「エキスパートシステム」や「オントロジー」が流行した。

エキスパートシステムでは、専門知をルール化して推論コンピュータに移植する。医療者、薬学者、細菌研究者、溶鉱炉のプロ、食品栄養学者、都市設計者、ケーキ職人、そのほか何であれプロのエキスパートの「知識」を「手順」ごとヒアリングして記述言語化し、これを入力方法に工夫を加えて充実させていくというやりかただ。知識をルール絡みに組み立てていくので「ルールベースAI」と呼ばれた。エドワード・ショートリフとブルース・ブキャナンが開発した感染症の血液病を診断する「MYCIN」(マイシン)が有名になった。医療の知識はコンピュータに入れやすかったのである。

われわれはふだん、慣用知や専門知や臨場知や制度知などを巧みに使って日常的な判断や日々のコミュニケーションをしている。これをコンピュータに代行させようとすると、いろいろな工夫をしなければならない。

専門知や制度知は学問の制度や法律の規定にもとづいて領域区分をしたり階層構造をつけたりすれば、なんとかなるのだが、けれども慣用知や臨場知はその知がおかれている「文脈」や「場合」を勘案しなければならない。

たとえば「あの林が危ない」という情報については、ふだんのわれわれはそのメッセージが日々の状況の中でどんなふうに発せられているかを感じて、その意味を予想する。最近イノシシが出たからあの林が危ないのか、雨で土砂崩れがおきそうなのか、犯人が逃げ込んだからあの林が危ないのか、そのいちいちを判断する。「あの林」の「あの」があらわす範囲も、話者や地域から分析しなければならない。

人間はこんなことにはあまり困らない。われわれが困らないのは、われわれがつねに社会や世間にいて(#われわれはつねにシチュエイティッドなのである)、そこで厖大な情報や知識をやりとりしてきたからだ。しかしコンピュータはそういう状況を体験していない(#だからシチュエイティッドをおこさなければならないわけだ)。そのため、コンピュータには「林」という概念をめぐる知識のすべてが用意されていなければならず、また「危ない」についての意味をその危険度の度合、何にとって危ないのか、その原因の一覧、危ないことでおこる傾向や結果の予測知などを“知らせて”おいてやらなければならない。

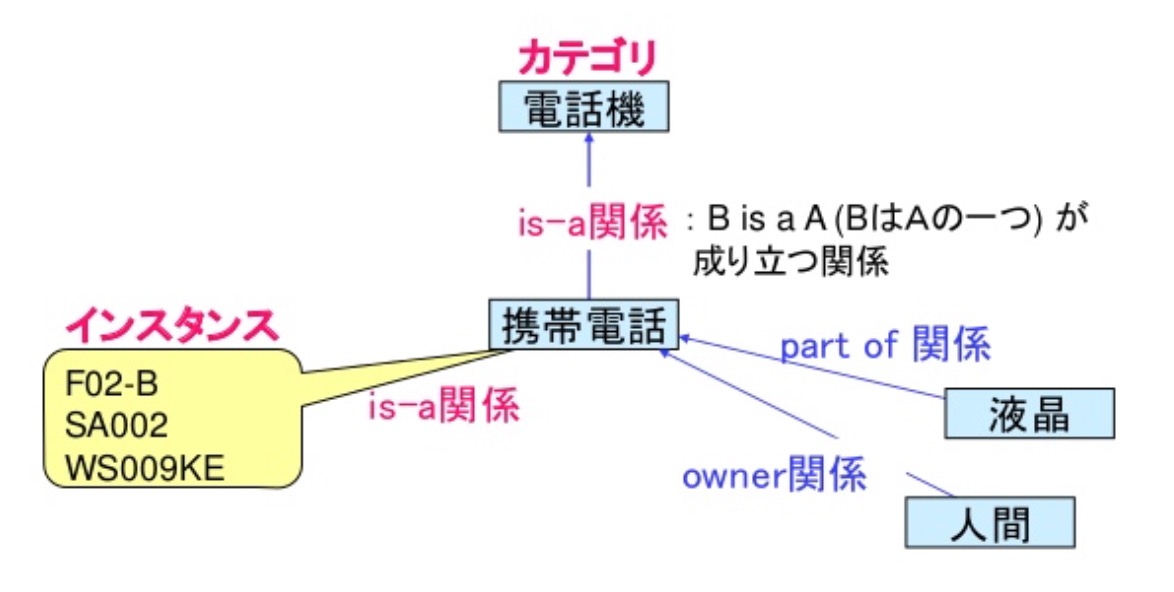

そこには「状況判断」のマップのようなものと、「意味ネットワーク」が用意されていなければならないのである。そのためには概念をノードであらわし、ノードどうしをリンクで結んでおく意味モデルをいろいろつくっておく。これがコンピュータの「知識表現」の前提になっていって、こうしてオントロジー型の手法が確立したわけだった。

オントロジーによるコンピュータの人工知能化は知識の工学化のひとつの手法となった。概念化がうまくセットされるように明示化のしくみを工夫したのだ。基本的には概念間の関係を「is-a」関係と「part-of」関係で記述していって、細かな概念マップをつくりあげていく。

その後、オントロジー研究はティム・バーナーズ=リーが提唱したセマンティックウェブの構想やLOD(Linked Open Data)に、また「ワトソン」のライトウェイト・オントロジーなどに発展した。ちなみに編集工学では「is-that」関係と「as-that」関係を重視する。柔らかいアナロジカル・シンキングを進めたいからだった。

第2次ブームでは、他方で並列推論システム(PIM)の実験に向かうという端緒も開かれた。厖大な情報と知識をしこたま入れて一気に計算してしまおうという計画だ。これには巨きくて高速の計算力が必要なので、結構な資金力が投入されなければならなかった。

かくて通産省の旗振りで総額570億円を投じた日本の「第5世代コンピュータ」(淵一博主導)の開発計画や、これに対抗したイギリスの「アルヴェイ」計画などが取り組まれたのだが、ことごとく挫折した。構文解析(パーサ)だけでも例外処理が厖大になって行き詰まってしまったのである。

それでもぼくとしては、当時は第5世代コンピュータの開発チームの周辺にいて(#チームの合言葉は「述語論理による推論を高速実行する並列推論マシンの開発」というもの)、このとき中島秀之や橋田浩一さんらの俊才に出会えたのが大きかった。北大の田中譲、北大から慶応に移った安西祐一郎、まだ企業にいた西垣通らと昵懇になったのもこのときだ。

第5世代コンピュータの挫折は大きかった。そのため、いつしか「記号処理」でも「ルール」でもAIは行き詰まるということで、またもや冬がやってきた。研究界も業界もかなり意気消沈し、AIに資金をつぎこむ国プロや企業もめっきりへった。

が、ここから静かに浮上してきたのが「機械学習」(machine learning)というものだったのである。

80年代、UCLAのジュディア・パールがベイズ確率をつかって事象の因果関係を確率的に推論する「ベイジアン・ネットワーク」を開発すると、しだいに音声認識に「隠れマルコフモデル」が使われたり、自動運転車の原理に「カルマン・フィルター」などが使われて、ひょっとするとこの方向から地味ではあるけれど新たな人工知能の可能性が開かれるのではないかと期待された。

それとともに、人工知能の“復活”を印象づけた出来事もおこっていった。もはや説明するまでもないだろうが、IBMの「ディープブルー」がチェスの世界チャンピオン(#ぼくが好きなガルリ・カスパロフだった)を破ったことや、日本のヒーローズの山本一成の「ポナンザ」や一丸貫則の「ツツカナ」がプロの将棋指しを連破していったのだ(#その経緯の一端は米長邦雄『われ敗れたり』1473夜に書いておいた)。

とくに「ワトソン」は多くのシステムに採用され、AI復活の機運を盛り立てた。約3000個の並列プロセッサが180種類のソフトウェアモジュールを駆使して動くというもので、わかりやすくいえば合計1000万冊の本の分量に相当するテキストデータを、1秒間に500ギガバイトの速度で処理できるようにした。そこには単語処理のためのデータベース、タクソノミー(単語の種類別分類)、オントロジー(単語の語義と単語どうしの関係処理)の機能もそなわっていて、しかも機械自身がやった処理を積み重ねながら自己学習できるようになっていた。

こうしたワトソンやポナンザの活躍こそは「ディープラーニング」という機械学習の徹底を敢行した成果だった。富士通の金澤裕治の「ナインデイフィーバー」は棋譜データの機械学習をし、山本の「ポナンザ」は8手先の局面を9億集めてこれを機械学習することを繰り返している。東大の「GPS将棋」はクラスタリングによる並列接続システムで、2013年の電王戦を制した。しかしそれらもいまや、グーグルの「アルファGo」にしてやられている。

やがて時代はビッグデータ時代にさしかかってきた。ここに登場してきたのがSVM(サポート・ベクター・マシン)やニューラルネットのニューヴァージョンなどである。

SVMはマージン(余地)をできるだけ最大にとったり、カーネル化という座標変換テクニックなどを駆使したりすることで、厖大なデータを巧みに区分けできるようにした。このような新たなニューラルネットは、ブルーノ・オルスホーゼンらの計算論的神経科学の導入やスパース・コーディング(sparse coding)が促進したディープラーニングによって目覚ましい成果を見せた。とくにトロント大学のジェフリー・ヒントンの先端性が注目された。

これらは、ヒントンの多層ニューラルネットのDBN(Deep Belief Network)がそうなのだが、変数となる特徴量(特徴ベクトル)を機械自身が発見できるようになっていた。ビッグデータを解析するためのデータサイエンティストたちが躍起になって入力していた特徴量が自動指定できるようになってきたことは、第3次AIブームがディープラーニングから湧き上がっていくだろうことを告示した(#最近、東大の松尾豊は「特徴表現量」という言い方でディープラーニングの長所を巧みに解説している)。

ニューロンマップの作成計画のほうもしだいに大規模になってきた。「脳のリバース・エンジニアリング」をやってのけようというものだ。

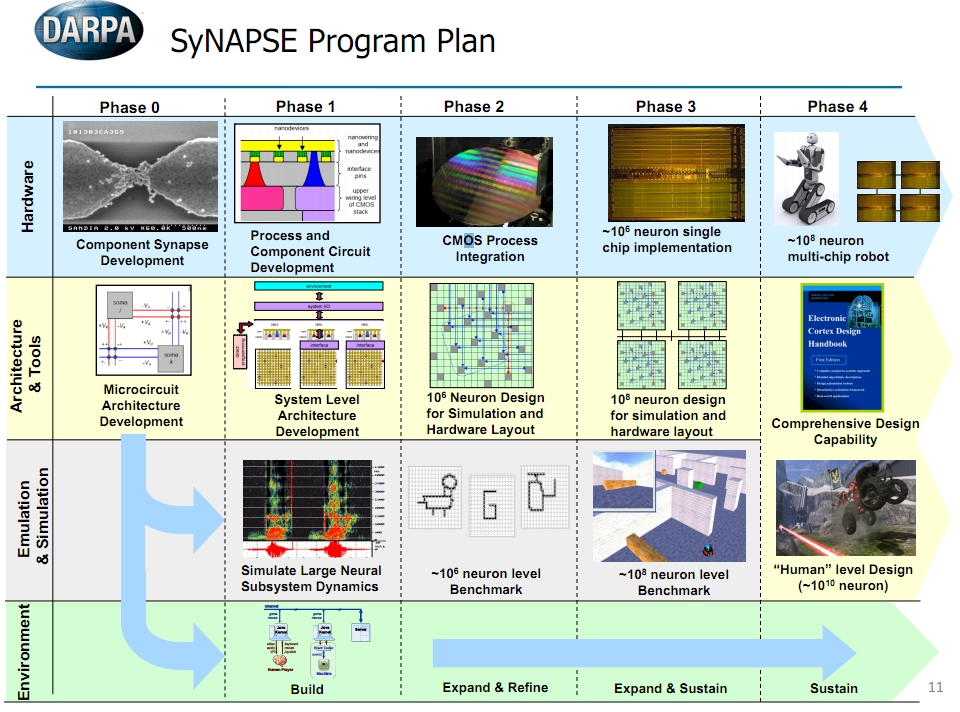

まずIBMの「SyNAPSEプロジェクト」が手を挙げた。DARPAから5300万ドルの資金提供を受けて、哺乳類の脳の機能模倣から始めてみようというものだ。プリンストン大学とグーグルも共同研究に乗り出した。複雑きわまるニューロンの接続図をできるだけ精緻にしようとするもので、総称して「コネクトーム」(connectome)づくりと言われる。プリンストン大学のセバスチャン・スンのチームもコネクトーム作成を始めた。いずれも1000億個のニューロンと1000兆個のシナプスによる脳のコネクトームをめざしている。

これにはEUも黙っていない。2013年、スイス連邦工科大学のヘンリー・マークラムの提唱による「ヒューマンブレイン・プロジェクト」(HBP)を立ち上げた。総額12億ユーロ(約1500億円)を投じるこの計画も、1000億個のニューロンをシミュレートさせた「人もどき脳」を分子レベルでマッピングしてしまおうというものである。それがアメリカに逆飛び火して、オバマ政権も30億ドル(約3600億円)の「ブレイン・イニシアティブ」計画を発表した。

もっとも、これらがはたして「本物の脳」にどのくらい近いのかはまったく予想できていない。たんなる“パイプ・ドリーム(現実離れの空想)”とも揶揄されている。

というわけで、いまや第3次AIブームになっているのだが、その8割以上はディープラーニングの積み重ねに、残りはAGI型の“パイプ・ドリーム”をめざすことになったのである。

さて、本書にはASIやAGIに警告を発した何人かのシステム工学者や重要な数学者やプログラマーが登場する。すでに亡くなった科学者もいる。アーヴィング・ジョン・グッドはその一人だ。

グッドは数学者で、第二次大戦時のドイツ軍の暗号を解読する「エニグマ」プロジェクトにおいてチューリングのもとで主任統計助手を務め、汎用コンピュータの開発のためにマンチェスター大学に招かれた。その後、チューリングは例の同性愛問題に巻き込まれたが、二人はいつもチェスを愉しんでいたらしい。いつもグッドが勝っていたようだ。チューリングはグッドに囲碁を教えたという。

グッドは1965年に『最初の超知能マシンに関する思索』を書き、超知能マシンは「知能爆発」をおこすだろうと予想した。そのため、最初の超知能マシンをつくるときが最も重大なので、大いに警戒すべきであると警告した。「最初の超知能マシンは人類がつくるべき最後の発明品になりかねない」というのだ。

90年代に入ると、グッドはANN(人工ニューラル・ネットワーク)の機能と将来に対する影響を考えるようになった。ANNは遺伝的アルゴリズムと同様にブラックボックスをもつ。これがあるかぎり(システムの中にブラックボックスがあるかぎり)、ANNはやがてAGIの危険をひそかに増大させていく要因になっていくだろうと、グッドは予想した。バラットはこのグッドの予想にもとづいて本書を書いたのである。

ヴァーナー・ヴィンジはSF作家として『遠き神々の炎』(創元SF文庫)や『最果ての銀河船団』(創元SF文庫)などで何度もヒューゴー賞をもらっている。短編集『マイクロチップの魔術師』(新潮文庫)は今日の社会がマイクロチップによってどのように変質するのか、みごとなSFに仕上げていた。

しかしヴィンジの本職は数学教授なのである。「シンギュラリティ」(技術的特異点)の概念を本格的に使いはじめたのはヴィンジだった。

宇宙にはシュバルツシルト半径というものが想定されている。ブラックホールに近づくとあらわれる「事象の地平線」を形成する半径で、この半径を超えると光が抜け出せなくなってしまう。ヴィンジは科学技術にもこのような「事象の地平線」があり、これを超えると予想不可能なことがおきると考えた。とくに人類が自分たちより知的な機能を考えようとすると、この一線に近づきすぎることになる。ヴィンジはこれが人工知能の将来に待っているシンギュラリティであると見た。

特定のAIならば、グーグルやSiriやワトソンがそうであるように、AIフレンドリーな状態が維持されるだろう。けれどもそこにセンシング技術が関与し、インターネットとIoTとユーザーとが一蓮托生のビッグデータとなってデジタルガイア化していくと、そのAIフレンドリーなマシンやシステムがついつい異様な発達をとげることになりかねない。ヴィンジはその状態は冷戦時代のMAD(相互確証破壊)のようなことを引き起こすかもしれないと見た。

とくに金融工学の周辺で「事象の地平線」を破る危険性がおこりそうだ。

かつて金融アナリストが市場のふるまいを予想するには、利率・雇用データ・住宅着工件数といったマクロな動きを組み合わせていればよかったのだが、いまはまったく異なっている。個人・企業・銀行・ヘッジファンドたちはそれぞれが自身のコンピュータモデルそのものと化していて、その何千何万の「主体」がエージェントとして相互戦略を読み合い、競い合っていく。そこにANNから遺伝的アルゴリズムまで、オートリードから隠れマルコフモデルまでの、あらゆるアルゴリズムが導入されていった。

これでは何がおこってもおかしくない。暴走もおこるだろう。ましてこのゲームでは「知能」ではなく「マネー」が剥き出しになる。ヴィンジはこのシンギュラリティを懸念した。

アレクサンダー・ウィスナー=グロスは日本にはめったにいない怪物だ。MITで物理学・電気科学工学・数学を修めてハーバードで物理学の博士号をとり、16件の特許を取得して幾つもの企業を創業しては売却し、金融工学の未来を見通そうとしている。

そのウィスナー=グロスは、今後のAGIの一線を超え、人工知能のシンギュラリティを破ってしまうのはクオンツであろうと予想している。クオンツは金融工学のプロのことである。

一人のクレイジーなクオンツがシンギュラリティを冒すのではない。多くのクオンツたちが関与したヘッジファンド・プログラムのアルゴリズム集合体が、シンギュラリティを破ってしまうだろうというのだ。

これはおこりうることだ。市場サーキットブレーカーが勝手に作動し、ラージトレーダールールが自動的に動く。それをコントロールするには「取引前アルゴリズム」や「AIソースコード監査」みたいなことをすることになるのだろうが、そのこと自体が人工知能的に自己判断してしまうということもある。

ところが、それでもいいではないか、そんな危惧を吹き飛ばしてAGIはみごとにシンギュラリティを自己管理するだろうと言い出したのが、ほかならぬレイ・カーツワイルだったのである。

ぼくはいまさらカーツワイルについて詳しく紹介するのが億劫な気分になっている。最初にカーツワイルを読んだのは2001年のことで、知人の田中三彦らが訳した『スピリチュアル・マシーン』だった。

テクノロジーの指数関数的な相互発達が、ニューラルネットと進化的アルゴリズムがエマージェントな自己組織化をおこすことによっていくらでも起爆していくだろうと予測したもので、それなりに斬新な統合感覚が迸(ほとばし)っていると見えたのだが、次の『ポスト・ヒューマン誕生』で「私はシンギュラリタリアン(特異点論者)だ」と名のり、「GNR同時革命を推進するのだ」と述べているのに出会って、いささか閉口した(#もっとも『ポスト・ヒューマン誕生』という邦題もよくなかった。原題は“The Singurarity is Near"である)。

GNRというのは遺伝子工学(G)とナノテクノロジー(N)とロボット工学(R)の接近と重合のことをいう。カーツワイルによれば、GNR革命はLOAR(Law of Accelerating Returns)によっておこる。「収穫加速の法則」だ。生物が分子進化によって急激に発展したように、技術も指数関数的に発展する。それだけではなく、いっさいがデジタル化されることによって、多くのハイテクノロジーが寄り添い、重なりあい、相互連関する。こうして近いうちにシンギュラリティに到達できるだろうというのである。

どうも行き過ぎた見方だった。しかしシンギュラリタリアン・カーツワイルの影響はかなり大きく、各業界に広まり、ひいては人工知能の開発加速に拍車をかけた。とくに「21世紀は感性と人工知能が融合する」は喝采をもって迎えられた。カーツワイルは、それは「セコイア」のように16ペタフロップスのスピードで1秒あたり1京6000兆回の計算できるようになれば、必ずや感性と人工知能は区別がつきにくいものになっているにちがいないと言う。

では、人工知能はこのままAGIに向かってGNR革命と一体になっていってよろしいのか。本書はそこになんとか楔を打ち込もうとしたわけだった。

正直なことを言うと、かつてぼくはダグラス・レナートが設計推進した「Cyc」(サイク)や、トム・ミッチェルが指揮をした「NELL」(ネル)がスタートしたことを知って、「ああ、これはがんばってほしい」と思っていた。

レナートの果敢な設計思想によってサイコープ社が取り組んだ「Cyc」は巨大な電子百科のようなもので、そのデータベースには100万語の単語と、その単語に関する約500万のルールや知識関連図が収められ、その最上位で推論エンジンが動いている。とくに技術的に特別なものではなく、1階論理という数理科学的な言明体系をつかって1000人年を費やしてしまおうという決然たるプロジェクトなのである。いまなお自然言語と自然言語処理(NLP)によって改良を続けているはずだ。当初の資金はDARPAなどが5000万ドルを提供した。

カーネギーメロン大学のミッチェルが牽引した「NELL」(Never Ending Language Learning)のほうは、いわば世界知・共同知・個別知を平等に収納しようとするシステムで、何億ものウェブページから文章パターンを次々にスキャンする。ウェットウェア(インターネットのユーザー)が直接に関与して作成しようという思想なので、いまでもNELLワークに参加する人材を募っている。ぼくが見たときはおよそ39万件の知識が入っていた。

しかし、これらは「知」を革新的に再構成するというものにはなっていない。あまりにも全面的でフラットで、統計学習的なのだ。がんばってほしいと思ったが、そろそろ次の展望が必要だろうと思われた。もっとも、トム・ミッチェルのETP理論は今後の可能性を少し感じさせる。タスク(T)とパフォーマンス測定(P)を、TとPに関連する経験(E)の機械学習によってマスターしていこうというものである。

これらに対してベン・ゲーツェルが設計開発しつつある「OpenCog」(オープンコグ)は、工学的なアプローチを駆使した概念理解型の認知アーキテクチャをめざしている。

これまで認知工学が扱う「パターン」は、すでに分類されているカテゴリーによって系統立てられた知識を援用するか、新たな入力データによってパターン認識を訓練させたパターン群の集合知を活用するというやりかたが主導してきた。ゲーツェルはそうではなく、カテゴリーそのものに記述を含んだ小さなプログラムを埋めこんでおくという発想にした。これはなかなか斬新な発想だった。そのため「OpenCog」の個々のモジュールは知覚・注意・記憶といった作業に向かえるようになった。

ただしゲーツェルはここから飛躍する。「赤ん坊AI」にあたるエージェントをつくり、その子を複雑にいりくんだ仮想世界の中に入れてどんなことになるかを見てみようというのだ。

というようなことで、やはりのことに、ついついシンギュラリティをめざすAIがあちこちにふえてきたのである。

なかにはゲーム・コンテストに勝つためだけの「ユリスコ」や「ネコマタ」のような鬼っ子もいた。また、ジェフ・ホーキンスのヌメンタ社が開発した停電予測AIや、ピーター・ヴォスのアダプティブAIのようにバーチャルエンジンやチャットボットのAI化を次々に打ち出すものも目立ってきた。メンフィス大学のLIDA(学習知能分散エージェント)のように海軍にAIを提供するところもある(#噂によるとLIDAは「原始的な意識の兆候」を見せているという)。

これらがステルス・カンパニーになっていくかどうかは、まだわからない。アップルのiPhoneに自然言語処理可能なパーソナルアシスタント・ソフトを入れたSiri社のように、みずから「ステルス・カンパニー」を自称する面々もいる。

むろん成功するとはかぎらない。SRIはDARPAの支援を受けてCALOという学習を体系づける認知アシスタントに取り組んで、ボーイング、カーネギーメロン、ハーバード、イェール大学など22の研究機関から300人の研究者を集めたが、「サーチ・エンジン」に対応する「ドゥ・エンジン」を開発するという触れ込みのわりには、ほとんど成果をもたらさなかった(#CALOからはTrapitというコンテンツ・コンシェルジュのような検索支援ツールが派生した)。

15章で構成された本書の最後の4章は「あまりにも、あまりにも複雑」「脳のリバースエンジニアリング」「AI研究にルールを作れるか」「もし社会インフラをAIに乗っ取られたら」になっている。

だいたい予想がつくように、AGIやASIはかなり複雑なものなので心配するほどには一筋縄ではいかないだろうこと、それにしてももしAGIが社会インフラや金融制度や生活の隅々に及んできたらどうするのかということを、両方論じている。また、何であれグーグルはそうした懸念をよそに(#やっぱりグーグルなのか)、けっこうなところまでのAI化を進めているだろうということも、いろいろ書いている。

エイモス・トヴェルスキーとダニエル・カーネマンが認知バイアスの研究に取り組みはじめたのは1972年にだった。かなり執拗に認知バイアスのプロセスを科学的に検証しようとしたので、カーネマンは2002年にノーベル経済学賞を受賞した。

かれらの研究によると、われわれはヒューリスティックな考え方や行動をする。人間は進化の過程でなるべくすばやい決断が役立つように、同じ思考の近道を繰り返すようになったからである。これが人間のヒューリスティックなところだが、それゆえしばしば非合理的な行動をとることもわかってきた。これを「可用性バイアス」という。最近の経験が判断や行動に影響を与えて非合理的な判断をしてしまうのだ。

もしわれわれが可用性バイアスの中にいつづけているのだとしたら、実はAIの活用はそのバイアスにぴったりのサポートシステムになってくれる可能性がある。なぜなら脳は最適化なんてできていないのだから、われわれがヒューリスティックになるにも最適な解答に達するにも、AIや超AIはまことにフレンドリーなのである。

ただそうなってくると、次には「脳の転写」がしたくなる。いわゆる「脳のリバースエンジニアリング」の計画だ。ダートマス大学のブレインエンジニアリング研究所のリチャード・グレインジャーがこの計画の一端を推進しつつある。

グレインジャーはコンピュータ科学によるトップダウン的な認知探求(#これを業界では「デノボな探索」という)には反対である。そうではなくて、脳の工学モデルを作っておいて、これをボトムアップで充実させていくという方法を提唱してきた。

脳のニューロンたちはそもそもが並列処理で、回路協調的である。グレインジャーは同僚のアショーク・チャンドラセカールとこのしくみを模倣した「教師あり」の学習アルゴリズムをつくり、並列プロセッサで動くようにしたのである。このモデルは再構成可能な並列処理チップとして特許を得た。

こうした試みは各所で進行中である。しかしながら、これらの研究開発をすべて容認していくとどうなるのか。また、これらの最先端のASIやAGIが金融や軍事に導入されたらどうなるか。このことについてはまったく予想がついていない。

ひょっとすると「AIのためのアポトーシス」(計画死)が必要になるかもしれないし、超AIが自分が閉じ込められていることを知ったら自己脱出を試みるだろうから、その防止プログラムを別途に用意しなければならないのかもしれない。いずれにしても原発事故でわかったように、自己爆発の危険をもったシステムは社会インフラには危険すぎるのである。

本書は、途中にも書いたようにうまくは構成されていない。それでも言いたいことが随所から洩れるようになっていて、しばしば意外なヒントをもたらしてくれたのである。

⊕ 『人工知能ー人類最悪にして最後の発明』 ⊕

∈ 著者:ジェイムズ・バラット

∈ 訳者:水谷淳

∈ 発行所:ダイヤモンド社

∈ 印刷所:勇進印刷・加藤文明社

∈ 装幀:松昭教(bookwall)

∈ 製本:ブックアート

⊂ 2015年6月18日 第一刷発行

⊗目次情報⊗

∈∈ はじめに

AIが人類を滅ぼす日

∈ 第1章 人類はこうして絶滅する

――ビジーチャイルド・シナリオ

∈ 第2章 一度起こればもはや手遅れ

――AIのリスクは予測不可能で計算できない

∈ 第3章 グーグルXとアルカイダに共通する怖さ

――人工知能の「知能」は人と同じか?

∈ 第4章 チューリングテストとAIボックス実験

――人工知能版「ロボット三原則」の設計は可能か?

∈ 第5章 「遺伝的プログラミング」の落とし穴

――AIの思考プロセスは「ブラックボックス」化する

∈ 第6章 人工知能の「4つの衝動」

――完璧に「経済合理的」なAIにとって人は必要か?

∈ 第7章 数学者グッドの予言

――「知能爆発」はどのようにして起こるのか?

∈ 第8章 金融マーケットで人知れず進化するAI

――人工知能はいつまで「人の道具」でいてくれるのか?

∈ 第9章 カーツワイルの「シンギュラリティー」再考

――人類は機械に追いつけるのか?

∈ 第10章 人工知能は「21世紀の核兵器」

――予防策はまだない

∈ 第11章 経済と軍事という2大要因

――膨大な資金は「誰」が出しているのか?

∈ 第12章 あまりにも、あまりにも複雑

――「ソフトウエア複雑性」は克服できても……

∈ 第13章 超知能を生む「脳のリバースエンジニアリング」

――……複雑すぎて人は人工知能を理解できない

∈ 第14章 AI研究にルールを作れるか

――「悪魔」を解き放つのは善意の研究者か、それとも

∈ 第15章 もし社会インフラを人工知能に乗っ取られたら

――コンピュータウイルスとAIの類似性

∈∈ おわりに

人工知能の危険は、今を生きるすべての人の問題である

∈∈∈ 訳者あとがき

⊗ 著者略歴 ⊗

ジェイムズ・バラット(James Barrat)

フリーのテレビプロデューサー。National Geographic、Discovery、PBSなどにさまざまなテーマのドキュメンタリー番組を提供している。2000年、本書にも登場するレイ・カーツワイルやアーサー・C・クラークに取材して以来、人工知能とその危険性に注目し、取材を重ねてきた。本書が初の著作である。2014年末、『タイム』誌が選ぶAIによる人類滅亡を論じる重要な識者5人に、スティーブン・ホーキングやイーロン・マスクとともに選ばれた。